Backup Do Chmury (Czyli 10 Powodów, Dla Których Musisz Przestać Robić Backup Na Taśmy)

Opiszę Ci dzisiaj dziesięć argumentów za pozbyciem się kopii zapasowych na taśmy i rozważenie backupu do chmury.

Rozpoczynając od kosztów infrastruktury, kończąc na bezpieczeństwie danych i ich trwałości, dowiesz się jak płacić mniej i poczuć się bezpieczniej w temacie kopii zapasowych i archiwów danych.

Musisz zrozumieć jedną, bardzo ważną regułę. Im bardziej Twój biznes skupia się na rozwiązaniach technologicznych i wykorzystuje dobrodziejstwa IT, tym większa szansa na utratę danych spowodowanych awariami dysków, błędami oprogramowania lub innymi zdarzeniami losowymi.

Nie ważne czy posiadasz już działające rozwiązanie kopii zapasowych w swoim data center, czy może rozważasz wykorzystanie taśm jako długo terminowe archiwum. Poświęć proszę kilka minut i rzuć okiem na dziesięć argumentów które dla Ciebie przygotowałem.

Dowiedz się dlaczego warto w pierwszej kolejności rozważać backup do chmury, a taśmy pozostawić jako drogą alternatywę.

#1 Koszty Infrastruktury Taśmowej

Zawsze szukaj oszczędności!

Co jeżeli powiem Ci że możesz ograniczyć koszty o 55% nawet jeśli posiadasz już istniejące rozwiązanie kopii zapasowych na taśmy w swoim data center?

Jako weteran kopii zapasowych, widziałem już bardzo wiele rozwiązań złożonych z najróżniejszego sprzętu i oprogramowania. TCO jest ogromnym problemem dla infrastruktury on-premises, dlatego chciałbym zwrócić Twoją uwagę na kilka najważniejszych generatorów kosztów:

Koszt Sprzętu

Biblioteki taśmowe wraz z napędami są jednym z większych kosztów podczas budowania infrastruktury, jeśli dorzucisz jeszcze SAN na Fibre Channel, koszty dodatkowo rosną.

Koszt Oprogramowania

Typowe oprogramowanie do wykonywania kopii zapasowych licencjonowane jest pojemnościowo (za każdy GB) lub za wykorzystane funkcjonalności (liczba napędów taśmowych, serwerów mediów, szyfrowanie).

Kolokacja i miejsce w rackach

Około 4U zajmuje sama biblioteka taśmowa zdolna pomieścić 30 taśm LTO5 (około 40TB surowej przestrzeni). Dodając do tego serwery kopii zapasowych, serwery mediów, tymczasowe przestrzenie dyskowe (półki z dyskami, macierze) – zauważysz że właśnie wykorzystałeś pół racka tylko po to aby uruchomić system kopii zapasowych.

Prąd i Chłodzenie

Im więcej sprzętu wstawiasz do data center, tym więcej prądu wykorzystujesz, a za tym idzie dodatkowy koszt związany z chłodzeniem tegoż sprzętu. Niejednokrotnie spotyka się rozwiązania do systemów kopii zapasowych sprzed kilku, nawet kilkunastu lat. Czy taki sprzęt działa optymalnie pod względem zużywanego prądu? Wątpię…

Duplikowany Sprzęt

Spodziewasz się awarii swojego data center? Z pewnością zadbałeś już o zakup dodatkowych napędów taśmowych, serwerów kopii zapasowych do swojego centrum zapasowego… Nie wspominając że taśmy z kopiami zapasowymi w jakiś sposób tam dotarły, a za zapasowe centrum i tak już sporo płacisz.

Gdybyś wykorzystał kopie zapasowe do chmury, mógłbyś uniknąć inwestycji i ukrytych kosztów. Poprzez eliminację kosztów oprogramowania, sprzętu, powierzchni w centrach danych, licencji i utrzymania, wejście w model chmurowy z pewnością się opłaci. Nawet jeśli posiadasz już gotowe i działające rozwiązanie, nadal musisz dbać o koszty utrzymania, odświeżać sprzęt itp. Nie jest za późno – czas na migrację kopii zapasowych do chmury. Zacznij oszczędzać!

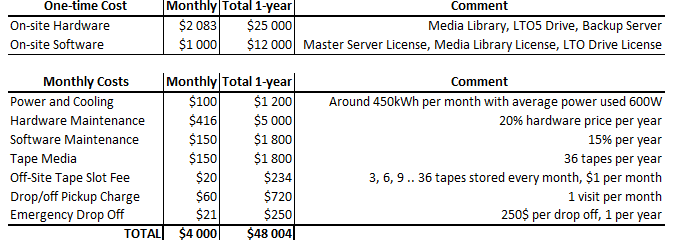

Dla przykładowego scenariusza poniżej, twój biznes potrzebuje wykonywać kopię zapasową 5TB danych na taśmy, co miesiąc i przechowywać je przez rok w zdalnej lokalizacji. Dodatkowo – raz w roku przeprowadzasz testowe odzyskanie takich kopi zapasowych.

TCO dla takiego rozwiązania w twoim data center (za 1 rok) to około $48.004. To prawie $4000 miesięcznie!

Dla rozwiązania chmurowego (AWS Storage Gateway w trybie VTL), wykorzystując istniejące oprogramowanie i licencje, AWS Storage Gateway działający jako biblioteka taśmowa.

Jak widać poniżej, bez specjalnej optymalizacji rozwiązanie kosztowało by około $21,150 rocznie i $1,763 miesięcznie! To cięcie kosztów na poziomie 56%.

Wyobraź sobie, że można pozbyć się istniejącego drogiego oprogramowania do tworzenia kopii zapasowych, a w ich miejsce użyć narzędzi przeznaczonych do tworzenia kopii zapasowych w chmurze, na przykład Acronis Backup Server lub Acronis Backup Server Advanced z licencją Acronis Cloud. Dzięki elastycznemu modelowi rozliczania pay-as-you-go, ograniczasz inwestycje i rozliczasz się tylko za wykorzystanie!

Średni czas spędzony na zarządzanie procesami tworzenia kopii zapasowych może zostać zmniejszony z 30 godzin tygodniowo do 5 godzin tygodniowo, oszczędzając organizacjom średnio 1300 godzin rocznie.

Czas spędzony na zarządzaniu odzyskiwaniem danych może zostać zmniejszony o 83%, co pozwala zaoszczędzić dodatkowe 750 godzin.

Dla większości podstawowych scenariuszy tworzenia kopii zapasowych, przejście na model chmurowy spłaci się samo poprzez eliminację kosztów utrzymania, licencji, przestrzeni centrum danych i przechowywania. Kopia zapasowa w chmurze może również pomóc w zgodności z różnymi regulacjami, normami i wymogami prawnymi, może służyć jako dowód (tzw. trzeci świadek) w celu zapewnienia, że twoje dane archiwalne nie zostały naruszone.

Niektórzy dostawcy rozwiązań chmurowych dają mechanizm Electronic Discovery – który jest w stanie zastąpić twój lokalny indeks plików na serwerach które zostały poddane kopii zapasowej i archiwizacji. Daje to możliwość znacznie szybszego przeszukiwania danych w archiwach niż byłbyś w stanie uzyskać w swoich dotychczasowych rozwiązaniach.

#2 Zgodność z Regulacjami i Bezpieczeństwo Danych

Większość dostawców usług kopii zapasowych w chmurze przechowuje dane w ośrodkach o bardzo wysokim poziomie bezpieczeństwa i ponosi duże koszty aby ten poziom bezpieczeństwa utrzymać i dodatkowo potwierdzać zdobytymi certyfikacjami.

Doświadczone zespoły specjalistów, monitoring 24/7, audyty bezpieczeństwa i zgodności z normami i regulacjami prawnymi.

Czy twoje dane przechowujesz w równie bezpiecznym miejscu?

Czy to samo możesz powiedzieć o rozwiązaniu w twoim Data Center?

Czy było by Ciebie na to stać?

Kopia zapasowa w chmurze jest znacznie bardziej odporna na awarię czy utratę danych niż klasyczne taśmy, dlatego że te same dane znajdują się jednocześnie w wielu rozproszonych i zaszyfrowanych kopiach, często w odległych od siebie lokalizacjach.

Dostawcy chmury wewnętrznie wykonują regularne sprawdzenia integralności danych, dbając o zachowanie odpowiedniego poziomu ich dostępności, dzięki czemu możesz wyeliminować te koszty tych procesów po swojej stronie.

Nawet najprostsze rozwiązania dla użytkowników końcowych, służące do tworzenia kopii zapasowych w chmurze (MyOtherDrive, BackBlaze) zapewniają szyfrowanie danych na wysokim poziomie (AES128 czy AES256) wszystkich przesyłanych oraz przechowywanych danych.

Przedsiębiorstwa często posiadają wewnętrzne polityki dotyczące sposobu składowania danych i kopii zapasowych. Bardzo często wpływ mają zewnętrzne obostrzenia narzucane przez regulacje prawne. Dlatego warto najpierw sprawdzić czy dostawca rozwiązania kopii zapasowej w chmurze spełnia nasze wymagania. Dobrym przykładem jest firma Venyu która na swojej stronie bardzo dokładnie wymienia listę spełnianych przez siebie regulacji zarówno pod względem danych składowanych w chmurze ale i samych ośrodków przetwarzania danych:

- SSAE SOCII (FORMERLY KNOWN AS SAS70 TYPE II) SOC2

- PCI COMPLIANCE

- HIPAA COMPLIANCE

- SARBANES OXLEY COMPLIANCE

- FINRA COMPLIANCE (NASD 3510)

Poniżej znajdują się trzy filary ochrony danych, czy twoje rozwiązanie on-premises jest w stanie spełnić te potrzeby?

Integralność Danych

Częstotliwość tworzenia kopii zapasowych może mieć wpływ na integralność danych w momencie gdy centrum danych zostaje zniszczone. Zestawy odtworzeniowe (Data Sets) muszą być tak zaplanowane aby możliwie najszybciej przywrócić sprawność środowiska. Kopie zapasowe muszą przechodzić weryfikację, zwłaszcza w przypadku gdy podczas awarii pliki zostały uszkodzone z dowolnego powodu, a każdy kolejny backup nadpisuje autentyczne (poprawne) pliki.

Bezpieczeństwo Danych

Taśmy i zewnętrzne dyski twarde są kosztowne, stosunkowo łatwo je uszkodzić i są podatne na starzenie się (w sensie technologii). Mogą być łatwym celem kradzieży, często zapomniane leżą gdzieś w magazynach, na dłuższą metę gubiąc się. Zdarzają się sytuacje gdy będziesz potrzebować jednoznacznej, nienaruszonej kopii swoich danych jako materia�ły dowodowe w przypadku procesów. Powinieneś zawsze przechowywać kopie zapasowe w formie zaszyfrowanej, zaś klucze szyfrujące powinny być trudno dostępne i dobrze strzeżone.

Dostępność Danych

Gdy padają się serwery, zatrzymuje się Twój biznes. Musisz przywrócić je do działania możliwie tak szybko, jak jest to możliwe. Próbujesz zapobiec utracie reputacji firmy i utrzymać ciągłość biznesową. Czy zastanawiałeś się, gdzie znajdziesz kilka wiadomości e-mail, gdy zostaniesz zmuszony do przedstawienia dowodów przed sądem? Czy będziesz w stanie odczytać swoje taśmy czy inne kopie zapasowe za 7-8 lat? Czy dane będą spójne? Tradycyjne kopie zapasowe są bardzo trudne do utrzymania w długim horyzoncie czasu, ciężko przewidzieć czy będziesz posiadać jeszcze w serwerach interfejsy dzięki którym podłączysz dyski twarde, biblioteki taśmowe… Większość z tych problemów można rozwiązać tworząc kopie zapasowe w chmurze.

Istnieje złota zasada kopii zapasowych “3-2-1” – powinieneś mieć 3 jednakowe kopie zapasowe na 2 różnych mediach i co najmniej jedną w lokalizacji poza siedzibą firmy.

#3 Warunki Składowania Taśm

W chmurze, dane są często rozproszone pomiędzy wieloma serwerami i lokalizacji w różnych regionach geograficznych. Dane w chmurze nie wymaga specjalnych warunków składowania w celu zapewnienia niemal dożywotniej integralności. W przypadku tradycyjnych kopii zapasowych on-premises może się wydawać rozsądnym przechowywanie taśm w bibliotece taśmowej w celu szybkiego dostępu. Pamiętajmy jednak że w przypadku poważnej awarii centrum danych – utracimy dostęp do tych taśm. Przechowywanie taśm w zdalnych lokalizacjach (off-site) wymaga pewnych warunków, aby zapobiec degradacji taśmy w czasie i zapewnić integralność zapisanych danych. Istnieją szczegółowe zalecenia dla uzyskania możliwie najdłuższej żywotności taśmy, ale są one trudne do utrzymania bez specjalistycznej klimatyzacji i systemów regulacji wilgotności. Dlatego należy korzystać z usług firm posiadających doświadczenie w składowaniu taśm off-site, posiadających własne specjalizowane lokalizacje, zapewniające wystarczającą kontrolę środowiskową, aby zmaksymalizować czas składowania archiwalnych taśm.

W chmurze, dane są często rozproszone pomiędzy wieloma serwerami i lokalizacji w różnych regionach geograficznych. Dane w chmurze nie wymaga specjalnych warunków składowania w celu zapewnienia niemal dożywotniej integralności. W przypadku tradycyjnych kopii zapasowych on-premises może się wydawać rozsądnym przechowywanie taśm w bibliotece taśmowej w celu szybkiego dostępu. Pamiętajmy jednak że w przypadku poważnej awarii centrum danych – utracimy dostęp do tych taśm. Przechowywanie taśm w zdalnych lokalizacjach (off-site) wymaga pewnych warunków, aby zapobiec degradacji taśmy w czasie i zapewnić integralność zapisanych danych. Istnieją szczegółowe zalecenia dla uzyskania możliwie najdłuższej żywotności taśmy, ale są one trudne do utrzymania bez specjalistycznej klimatyzacji i systemów regulacji wilgotności. Dlatego należy korzystać z usług firm posiadających doświadczenie w składowaniu taśm off-site, posiadających własne specjalizowane lokalizacje, zapewniające wystarczającą kontrolę środowiskową, aby zmaksymalizować czas składowania archiwalnych taśm.

Podczas transportu nie powinno być śladów kondensacji wilgoci ani wewnątrz ani na zewnątrz taśmy. Właściwe opakowanie taśm jest konieczne, aby zagwarantować żywotność i integralności danych na niej zawartych. Taśmy dostarczone w nieodpowiednio zabezpieczonych opakowaniach mogą zostać uszkodzone, co może spowodować utratę danych lub zmniejszenie żywotności taśmy.

Pole magnetyczne znajdujące się w okolicy taśm nie może przekraczać wartości 4,000 A/m.

Jeżeli temperatura otoczenia taśmy wzrośnie ponad 52° C może spowodować jej trwałe uszkodzenie. Jeśli podczas przechowywania i / lub transportu taśmy została ona wystawiona na działanie niesprzyjających warunków, przekraczających zalecane wartości, musi być przygotowana przed użyciem poprzez wystawienie na działanie środowiska operacyjnego (docelowego) przez czas równy lub większy niż czas spędzony poza optymalnymi warunkami, jednak nie więcej niż 24 godziny.

Wszystkie powyższe wymagania powinny być spełnione jeżeli chcemy dbać o spójność danych zapisanych na taśmach.

#4 Procedury Trudne W Utrzymaniu

Dla każdego długotrwałego przechowywania lub archiwizacji danych, musi istnieć procedura, dzięki której zespoły utrzymania będą wiedziały jak bezpiecznie przechowywać taśmy, trafią one do odpowiednich lokalizacji. Zostaną opisane, sklasyfikowane, oznaczone i ewentualnie trafią do wewnętrznych systemów ewidencyjnych. W każdej chwili będzie wiadomo gdzie taśma się znajduje, kto ostatnio ją pobrał/deponował wraz z dokładną datą i czasem. Jeśli przechowujesz taśmy na miejscu, transport nie jest tak dużym problemem, ale postaraj się aby personel wiedział jak w odpowiedni sposób transportować taśmy z bibliotek taśmowych do miejsc ich składowania, nawet jeżeli jest to ten sam budynek. Wszystko to wymaga opisania w jasny sposób w postaci procedur, przeprowadzenia krótkich szkoleń, których aktualność wymaga nakładu pracy i jest trudna w utrzymaniu. Na sam koniec warto wspomnieć że ludzie mają w nawyku upraszczanie sobie pracy, przez co często nie spełniają oni wymagań podczas zajmowania się nośnikami kopii zapasowych.

Po co się męczyć?

Niech chmura zadba o twoje kopie zapasowe i archiwa, zapewni elastyczne indeksowanie plików i przeszukiwanie archiwów, zapewni automatyczną retencję i rotację danych gdy ich czas przechowywania dobiegnie końca. Zaoszczędź swoje cenne pieniądze na redukcji zadań potrzebnych do wykonania i przeznacz na pracowników zdolnych zaprojektować dla ciebie takie rozwiązanie (architektów rozwiązań), tak aby możliwie najwięcej czynności stało się automatycznych i zoptymalizowanych.

Oszczędności pojawią się bardzo szybko!

#5 Wynajem Przestrzeni Off-Site

Przechowywanie taśm nie jest darmowe.

Ośrodki zapasowe alokują koszty kolokacji, sieci, duplikowanych urzadzeń i oprogramowania. Profesjonalne usługi przechowywania taśm także są kosztowne. Średnia cena za jedną taśmę waha się od $0,50 do $4 za miesiąc. Jeśli porównać to do Google Nearline Storage lub AWS Glacier gdzie płacisz jedynie only $0.01 za GB/miesiąc, cena kilku dolarów wydaje się być w miarę rozsądna.

Spróbuj jednak dodać do tego koszt nośnika.

Nadal wydaje się rozsądne?

W zasadzie jeżeli nie ponosisz dodatkowych kosztów związanych z transportem (konwoje, torby zabezpieczane szyfrem z wbudowanym paralizatorem), przechowywanie taśm off-site jest dość opłacalne. Pamiętaj jednak że odległe ośrodki zwiększają czas na przywrócenie danych związany głównie z transportem samych taśm a potem ich zaklimatyzowaniem. Wykorzystując kopie zapasowe w chmurze, możemy łatwo wyeliminować te czynniki. Na koniec warto dodać że same taśmy nie pozwolą ci przywrócić biznesu do życia, przy poważnej awarii potrzebujesz także całej infrastruktury w ośrodku zapasowym, sztabu kryzysowego wraz z zespołami gotowymi podjąć się procedur podniesienia ośrodka po awarii..

Przy średniej cenie $2 za taśmę składowaną off-site miesięcznie, otrzymujesz około 1,5TB danych na taśmie LTO5.

Za 2$ można dostać tylko 200GB do przechowywania kopii zapasowych w chmurze, gdzie są zawsze dostępne, gotowe do użycia, bezpieczne i indeksowane. To z pewnością nie jest argumentem, jeśli jedyne co planujemy to przechowywanie zapisanych taśm, ale zaczyna mieć znaczenie gdy zwrócimy uwagę na czasy przywrócenia danych i ilość sprzętu potrzebnego do odzyskania danych z taśm.

#6 Długie Czasy Transportu i Przywrócenia Danych

Zakładając, że twoje kopie zapasowe są w przechowywane w zdalnym ośrodku ze względów bezpieczeństwa, czasy dostępności taśmy do rozpoczęcia procesu odzyskiwania wahają się w zakresie od 1 godziny do 24 godzin (wyższe czasy to już poważne zagrożenie dla biznesu).

Rozważ to zanim nadejdzie moment w którym musisz przywrócić biznes do życia po poważnej awarii.

Największą jednak wadą rozwiązań taśmowych jest to, że dane na taśmie mogą być dostępna tylko w sposób liniowy (bardzo długie czasy seek-time), co sprawia, dostęp do danych odbywa się o wiele wolniej niż w rozwiązaniach chmurowych. Przeszukiwanie wielu taśm bez porządnego rozwiązania katalogowego potrafi w sytuacji kryzysowej wpędzić do grobu.

Duża większość przedsiębiorstw dokonuje “zubożenia” katalogu, ponieważ oprogramowanie do kopii zapasowych przestaje być wydajne przy jego odpowiedniej wielkości. Tracimy wtedy szczegóły które mogą nam uratować biznes, oszczędzić czasu na szukaniu.

Pierwszym krokiem jest eliminowanie atrybutów plików przechowywanych w katalogach – spora oszczędność pojemności i wydajności, następnie usuwane są listy plików z katalogów – pozostaje jedynie drzewo katalogów do przeszukania. W wielu wypadkach jest to pożądane i wystarczające, dając efekt szybkiego działania oprogramowania do kopii zapasowych. Jednak moment w którym uszkodzeniu ulega katalog – jest jednym z bardziej stresujących dla operatora kopii zapasowych. Jeżeli wcześniej procedurą nie objął taśm które zawierają kopię zapasową katalogu i nie wie gdzie on się znajduje – rozpoczyna się proces importowania wszystkich taśm w celu odnalezienia kopii zapasowej katalogu, aby móc przystąpić do właściwego odzyskania!

Gdy na szali leży ciągłość biznesowa, widok administratora “przewijającego taśmy” w poszukiwaniu danych może nie być pożądany.

Dlatego posiadając dobrego architekta rozwiązań, podpowie ci że jedną z dobrych praktyk jest katalogowanie “najważniejszych” taśm w systemach zewnętrznych – niech to będzie notatnik/wiki/naklejka na taśmach w sejfie. Da ci to spokój ducha i pozwoli spać o wiele spokojniej.

Pamiętaj – statystycznie 93% firm, które utraciły 10 dni danych zbankrutuje w ciągu roku!

Korzystając z rozwiązań kopii zapasowych w chmurze, problem wyszukiwania danych jest wyeliminowany, ponieważ dostawca usług posiada już zbudowany indeks twoich kopii zapasowych, gotowych do przeszukiwania z całą historią wstecz. Dla przykładu SOS Online Backup posiada politykę ForeverSave Archive and Version History, dzięki czemu pamięta wszystkie twoje kopie zapasowe, wszystkie ich wersje oraz wersje plików które zawierały – na zawsze! O to właśnie chodzi w nowoczesnym myśleniu, to właśnie są rozwiązania które lubię najbardziej jeśli chodzi o selektywne odtwarzanie kopii zapasowych z chmury.

Ostatnia rzecz w temacie taśm…

Średni czas dostępu to 50 sekund zaś 80 sekund trwa przewijanie taśmy. Selektywne przywracanie danych może ci się strasznie dłużyć…

#7 Niska Żywotność/Wiarygodność Taśm

W porównaniu do składowania danych w chmurze, gdzie najczęściej wykorzystuje redundantne, rozproszone, automatycznie naprawiające się rozwiązanie oparte na dyskach twardych, taśmy wyglądają na naprawdę mało wiarygodne.

Szacowana trwałość to 200-250 pełnych zapisów/odczytów dla taśm LTO5. To daje około 17 lat życia taśmy, przyjmując jej pełny zapis raz na miesiąc lub 4 lata zapisując pełną taśmę raz w tygodniu. Producenci określają także ilość załadowań/wyjęć taśmy z napędu na około 5000 razy.

Standard taśm LTO automatycznie przeprowadza sprawdzenie odczytu bloku zaraz po jego zapisie, w celu weryfikacji czy dane które na taśmę trafiły są spójne. Niestety dla niektórych konfiguracji oprogramowania kopii zapasowych, taka weryfikacja jest wykonywana dodatkowo – prawdopodobnie zupełnie niepotrzebnie, zaraz po zakończeniu wykonywania polityki kopii zapasowych.

Zmniejsza żywotność taśmy o połowę!

Gdy taśma zaczyna zgłaszać pierwsze problemy podczas weryfikacji zapisu, a czyszczenie napędu taśmowego nie pomaga, należy jak najszybciej skopiować wszystkie dane mieszczące się na tej taśmie aby uniknąć ich utraty bądź uszkodzenia. Taka taśma powinna zostać usunięta z procesu i przekazana do recyklingu.

Dla rozwiązań chmurowych weźmy za przykład Amazon S3 który został zaprojektowany aby dawać 99.999999999% trwałości pojedynczych obiektów w okresie roku. Ten poziom trwałości odpowiada średniej rocznej oczekiwanej utracie 0,000000001% obiektów.

Na przykład, jeśli przechowujemy 10.000 obiektów w Amazon S3, możemy się spodziewać utraty jednego obiektu raz na 10.000.000 lat!

Ponadto, Amazon S3 zaprojektowany jest tak, że możliwa jest jednoczesna utrata dwóch centrów danych AWS, bez żadnej straty danych! Amazon S3 wykorzystuje zaawansowane połączenie sum kontrolnych MD5 dla obiektów i CRC dla bloków danych w celu wykrycia ich uszkodzenia. Dane sprawdzane są cyklicznie, odbywa się to w “tle”, nie wpływając na ich dostępność. W przypadku znalezienia nieprawidłowości, dane są automatycznie naprawiane wykorzystując redundancję i sumy kontrolne.

Ponadto AWS oblicza sumy kontrolne dla ruchu sieciowego w celu wykrycia uszkodzeń pakietów danych podczas zapisywania lub odczytywania. Jeśli potrzebujesz tańszego niż AWS S3 rozwiązania – wybierz Amazon Glacier.

#8 Szybki Przyrost Danych

Przyrost ilości danych jest czymś naprawdę nieprzewidywalnym. Można tworzyć wykresy trendów, oszacować zwiększenie rozmiaru danych, zaangażować zaawansowaną analitykę, ale nigdy nie wiadomo dokładnie, co stanie się w ciągu najbliższych 2-3 lat. Oczywiście zawsze można kupować taśmy w paczkach po 50 sztuk, w nieskończoność filtrować i optymalizować polityki kopii zapasowych.

W najlepszym wypadku nigdy nie zabraknie ci taśm na bieżące kopie zapasowe i unikniesz “niespodziewanych” inwestycji w nowe taśmy. Przychodzi jednak moment w którym napęd LTO5 musi zostać wymieniony ze względów pojemności czy też wydajności wykonywanych kopii zapasowych.

Nawet się nie obejrzysz gdy dojdziesz do punktu w którym będziesz musiał utrzymywać “stare” napędy LTO5 tylko ze względu na kompatybilność z taśmami archiwalnymi sprzed 3-4 lat.

Oczywiście jest alternatywa – możesz taśmy kopiować, konsolidować, wykorzystywać coraz nowsze nośniki – ale jest to bardzo czasochłonny proces!

Wykorzystując kopie zapasowe w chmurze, płacisz jedynie za to co wykorzystujesz. Nie ma żadnego limitu danych które możesz przechowywać. W większości przypadków z biegiem czasu ceny są coraz niższe (nie jest to regułą – co pokazał ostatnio Microsoft Azure – podnosząc ceny dla rejonu EU).

Dodatkowo im więcej składujesz danych tym ceny są zwykle jeszcze niższe. Wisienką na torcie jest praktycznie zerowy nakład inwestycyjny, łatwość zarządzania, rozliczanie i raportowanie, płatność w modelu miesięcznym i rezygnacja z usługi wtedy kiedy chcesz. O to właśnie chodzi w chmurze!

#9 Koszty Licencji

Przyrost ilości danych jest trudnym tematem, w szczególności jeśli chodzi o standardowe modele licencjonowania oprogramowania, jako że większość z nich opiera się na licencjonowanej pojemności (GB danych).

Porównując to do rozwiązania kopii zapasowej w chmurze, można przyjąć że “niewidoczny” koszt oprogramowania zaszyty jest w twojej cenie za GB danych, czyli wydaje się że oprogramowanie dostajemy “gratis”. Wykorzystywanie klasycznego oprogramowania powoduje że wzrost ilości danych wpływa niekorzystnie przede wszystkim na prędkość wykonywania kopii zapasowych. Każdy kolejny napęd może być objęty dodatkową licencją, kolejne GB danych potrzebują kolejnych licencji. Z czasem serwery mediów także przestają się wyrabiać i potrzebujesz dokupić kolejny – z kolejnymi licencjami…

Często lepiej jest zainwestować w oprogramowanie wspierające globalną deduplikację, np. Ctera Cloud Storage Gateway, dzięki której dane końcowe, zdeduplikowane trafiają do chmury. Pozwala to dodatkowo na rozciągnięcie istniejących rozwiązań storage do chmury. Wszystko to jest kwestią szczegółowych kalkulacji i wiedzy eksperckiej.

#10 Planowanie Pojemności

Nie ważne jaki model kopii zapasowych będzie wykorzystywany, jeśli planujesz pojemność rozwiązania, ZAWSZE KATEGORYZUJ SWOJE DANE.

Istnieją setki typów plików, kategorii użytkowników, polityk bezpieczeństwa danych, serwerów pełniących kluczowe role w przedsiębiorstwie. Niektóre dane muszą być składowane w formie niezaprzeczalnej, zachowując ich wszystkie możliwe atrybuty, podczas gdy inne w zasadzie nie są istotne, rzadko się zmieniają. Proces ten wymaga dużego doświadczenia oraz współpracy z biznesem, aby dokładnie wiedzieć które dane są najbardziej istotne, które dane w przypadku awarii muszą zostać odzyskane z najwyższym priorytetem. Dlatego też parametry RTO i RPO głównymi kwalifikatorami ściśle związanymi z planowaniem polityk kopii zapasowych, planów ciągłości działania i przygotowywania planów przywrócenia po awarii.

Recovery Point Objective

RPO określa maksymalny dopuszczalny punkt czasu do którego możemy sobie pozwolić na utratę danych. Np. dla RPO wartości 4 godzin, zgadzamy się na utratę ostatnich 4 godzin pracy naszego biznesu w przypadku krytycznej awarii wymagającej uruchomienia w centrum zapasowym. To przede wszystkim wpływa na harmonogram tworzenia przyrostowych kopii zapasowych i zwykle przyjmuje się okres 24 godzin dla kopii przyrostowych wykonywanych raz dziennie. Parametr można zbliżać do wartości bliskiej zera, pod warunkiem wykorzystywania replikacji danych z dużą prędkością.

Recovery Time Objective

RTO określa na jak długo można w zatrzymać biznes, aplikacje, lub przeżyć bez konkretnych danych. Np. dla RTO wartości 24 godzin, zgadzamy się że biznes zostanie przywrócony do życia w tym okresie czasu i może być przez ten czas całkowicie niedostępny.

Istnieje pięć czynników które pomogą ci oszacować jak wiele pojemności systemu kopii zapasowych potrzebujesz dla danego rozmiaru danych:

- Rozmiar pełnej kopii zapasowej wszystkich danych które potrzebujesz aby przetrwały.

- Rozmiar i częstotliwość przyrostowych kopii zapasowych.

- Okres czasu przez który kopie zapasowe będą przechowywane

- Czas po którym kopie zapasowe podlegają archiwizacji i są przeniesione off-site

- Przyrost rozmiaru danych

Pełne i przyrostowe kopie zapasowe (współczynnik 1 i 2) są proste i mogą być określone np. poprzez sprawdzenie wielkości tygodniowych kopii zapasowych. Oczywiste jest, że chodzi o pełną tygodniową kopię zapasową wszystkich danych potrzebnych do odzyskania biznesu po całkowitej awarii ośrodka podstawowego.

Codzienne kopie przyrostowe zwiększają aktualność danych. Kopie przyrostowe zajmują zwykle 3-10% wielkości kopii pełnych. Często udaje się zoptymalizować aby sześć dni kopii przyrostowych zamykało sie w 15% pojemności kopii pełnej. Istnieją funkcjonalności oprogramowania które pozwalają na wykonywanie wirtualnych kopii pełnych (virtual full backup) lub wykorzystanie jednej kopii pełnej i tylko kopii inkrementalnych (always incremental). Oparte są na jednej pełnej kopii zapasowej i kolejnych kopii przyrostowych wykonywanych przez określony okres czasu. Po tym okresie wszystkie kopie przyrostowe konsolidowane są do tak zwanej wirtualnej kopii pełnej. Dzięki temu nie ma potrzeby wykonywać ponownie kopii pełnej, a wirtualną kopię pełną nagrywamy na taśmę tak jak zwykłego fulla. W drugim przypadku, zawsze posiadamy jedną kopię pełną, a kolejne kopie przyrostowe konsolidowane są do jednej kopii przyrostowej i zapisywane na taśmę.

Czynnik trzeci opisuje czas przez jaki kopie zapasowe muszą być przechowywane. Niektóre pliki są mniej ważne od innych, dlatego zawsze kategoryzuj swoje dane. Pliki dziennika logów i e-maile mogą być kluczowe jako materiał dowodowy. Pliki tymczasowe, pliki multimedialne użytkowników mogą zostać łatwo wykluczone z kopii zapasowych lub przechowywane przez krótki okres czasu.

Czwarty czynnik mówi o okresie czasu po którym kopie zapasowe przechowywane on-premises powinny zostać przewiezione do ośrodka zapasowego lub zdalnej lokalizacji.

Piąty czynnik to przyrost ilości danych. Przyjmuje się około 1,5 do 2,0-krotny przyrost roczny.

Wszystko to jest wspólne dla tworzenia kopii zapasowych zarówno w chmurze i w klasycznym modelu. Główną różnicą jest to, że w przypadku korzystania z tworzenia kopii zapasowych na miejscu, planowanie pojemności obejmuje konserwację sprzętu i jego modernizację, wymiany taśm, zwiększanie rozmiarów bibliotek i ogromne ilości siły roboczej zespołów utrzymania które zmuszone są wykonywać większość czynności ręcznie.

Dlatego w pierwszej kolejności należy zawsze starać wykonywać kopie zapasowe w chmurze, a następnie wykorzystywać taśmy jako alternatywę.

Oszczędzisz czas… bardzo dużo czasu! Wiadomo nie od dziś że czas to pieniądz!

Podsumowanie

Mam nadzieję że przynajmniej przeczytałeś moją listę 10 argumentów, aby rozważyć backup do chmury. Z pewnością ułatwi ci to przeprowadzenie trudnej rozmowy z zespołem zajmującym się utrzymaniem ciągłości działania, opiekującym się systemami kopii zapasowych.

Zawsze warto konsultować rozwiązanie z zewnętrznym konsultantem, a liczby nie kłamią.

Na dłuższą metę, pozwoli ci na podjęcie świadomych decyzji.

Ułatwi zadawanie ekspertom odpowiednich pytań.

Pozwoli ci szacować koszty i zwiększać oszczędności.

Już 21 czerwca dowiesz się, jak możesz wykorzystać AI w Twojej firmie. Damian Mazurek i Piotr Kalinowski wprowadzą Cię w świat sztucznej inteligencji i LLM.

Przed nami nowy rozdział! Chmurowisko dokonało połączenia z polskim Software Mind – firmą, która od 20 lat tworzy rozwiązania przyczyniające się do sukcesu organizacji z całego świata…

Grupa Dynamic Precision podjęła decyzję o unowocześnieniu swojej infrastruktury. Razem z Oracle Polska prowadzimy migrację aplikacji firmy do chmury OCI.

Już 21 czerwca dowiesz się, jak możesz wykorzystać AI w Twojej firmie. Damian Mazurek i Piotr Kalinowski wprowadzą Cię w świat sztucznej inteligencji i LLM.

Zapisz się do naszego newslettera i

bądź z chmurami na bieżąco!

z chmur Azure, AWS i GCP, z krótkimi opisami i linkami.